В понедельник Uber запустил свой парк автономных автомобилей (Ford Fusions) в Питтсбурге, штат Пенсильвания. Тест представляет собой смелое видение генерального директора Uber Трэвиса Каланика, который однажды развернет целый парк автономных транспортных средств, чтобы заменить примерно 1,5 миллиона водителей компании и переправлять пассажиров, посылки и еду по городским центрам. Тем временем Uber превращает Питтсбург в экспериментальную лабораторию, призывая общественность к участию до того, как будут написаны какие-либо законы. Uber пригласил до 1000 своих самых лояльных клиентов из Питтсбурга испытать футуристические автомобили в ходе первого в США реального испытания беспилотных автомобилей для обычных людей. Это первый публичный тест с использованием людей в качестве подопытных кроликов. Посмотрим, как они обходятся без колеса…

Также в понедельник японский производитель БПЛА Prodrone выпустил первый коммерчески доступный беспилотный летательный аппарат с двумя роботами-манипуляторами (подобный клешне). Его когти поднимают более 40 фунтов груза и предназначены для использования в морских и наземных спасательных операциях. Однако он ограничен расстоянием в пределах 30 минут на скорости 37 миль в час.

По словам генерального директора Prodrone Масакадзу Коно, «он может работать на высоте, собирать опасные материалы и доставлять грузы в отдаленные районы… Сложный алгоритм поддерживает устойчивость дрона, поскольку его центр тяжести смещается при использовании манипуляторов робота».

Компания ожидает, что в будущем она сможет выполнять больше «практических» задач, таких как перерезание кабелей, поворот циферблатов, щелканье переключателями и, возможно, другие работы, слишком опасные, грязные или скучные для человека. Далее Коно восклицает: «Мы твердо нацелены на будущее коммерческих дронов и на то, чтобы стать мировыми пионерами в разработке специализированных дронов».

Хотя видео очень впечатляет, оно напоминает фильм ужасов современного ремейка хичкоковского Птицы (Дроны).

Руки тяжелые. У роботов много сильных сторон, но деликатность традиционно не была одной из них. Жесткие конечности и пальцы мешают им хватать, удерживать и манипулировать целым рядом предметов повседневного обихода, не уронив и не раздавив их. В прошлом году исследователи из Массачусетского технологического института обнаружили, как использовать силикон, плавящийся на воздухе, для наилучшего обращения с хрупкими объектами, такими как помидоры или яйца. Это породило новую отрасль модульных захватов, известную как мягкая робототехника для сельского хозяйства, складирования и производства.

По словам профессора Массачусетского технологического института Даниэлы Рус, «роботы часто ограничены в своих возможностях из-за сложности взаимодействия с объектами разных размеров и материалов. Хватание — важный шаг на пути к выполнению полезных задач; с помощью этой работы мы решили разработать как мягкие руки, так и поддерживающие системы контроля и планирования, которые делают возможным динамическое хватание».

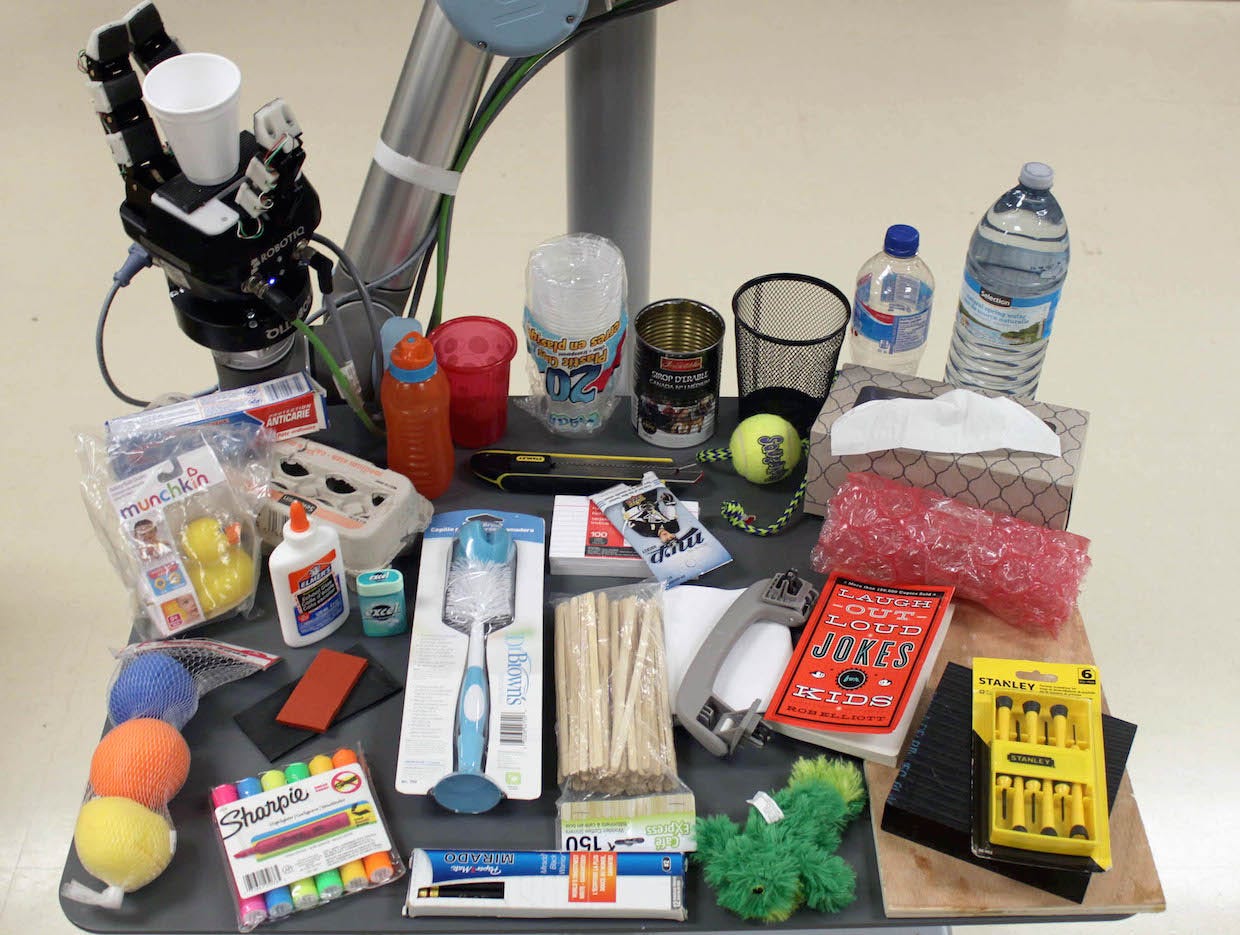

Робототехники, такие как Русь, стремятся разработать робота, который может поднимать что угодно, но сегодня большинство роботов выполняют «слепой захват», когда они предназначены для того, чтобы каждый раз поднимать объект из одного и того же места. Если что-то изменится, например, форма, текстура или расположение объекта, робот не будет знать, как реагировать, и попытка захвата, скорее всего, не удастся.

Роботы все еще далеки от того, чтобы с первой попытки идеально схватить любой объект, даже мягкие роботы. Почему задачи на схватывание представляют собой такую сложную проблему? Итак, когда люди пытаются что-то понять, они используют комбинацию органов чувств, основными из которых являются зрительные и тактильные. Но до сих пор большинство попыток решить проблему схватывания были сосредоточены на использовании только зрения.

Профессор Винсент Дюшен из École de Technologie Supérieure (ÉTS) в Монреале, Канада, написал этим летом в журнале IEEE Spectrum Magazine, что «текущее внимание к роботизированному зрению вряд ли обеспечит идеальное схватывание. Помимо зрения, будущее роботизированного хватания требует чего-то еще: тактильного интеллекта».

Он сравнивает эту задачу с тем, как в знаменитом дискурсе Стивена Пинкера Как работает разум описаны все действия, выполняемые человеческим осязанием: Представьте, что вы поднимаете пакет молока. Слишком слабая хватка, и вы ее уроните; слишком туго, и вы раздавите его; а при легком покачивании вы даже можете использовать подергивание кончиков пальцев для определения того, сколько молока внутри! Дюшен утверждает, что, поскольку роботам не хватает этих сенсорных возможностей, они все еще сильно отстают от людей, когда дело доходит до самых простых задач по сборке и перемещению.

До сих пор большая часть исследований роботизированного хватания была направлена на создание интеллекта на основе визуальной обратной связи. Один из способов сделать это — сопоставление изображений в базе данных, метод, используемый в Million Objects Challenge в лаборатории Brown’s Humans to Robots Lab. Идея состоит в том, чтобы робот использовал камеру для обнаружения целевого объекта и отслеживания собственных движений, когда он пытается схватить объект. При этом робот сравнивает визуальную информацию в реальном времени с отсканированными 3D-изображениями, хранящимися в базе данных. Как только робот находит совпадение, он может найти правильный алгоритм для своей текущей ситуации.

Другие исследователи обратились к методам машинного обучения для улучшения хватания роботов. Компания Google недавно провела эксперимент по захвату технологий, сочетающих систему машинного зрения с машинным обучением. Самый большой прорыв Google состоял в демонстрации того, как роботы могут обучаться — используя глубокую сверточную нейронную сеть, систему зрения и большой объем данных (более 800 000 попыток захвата) — чтобы совершенствоваться на основе того, что они узнали из прошлого опыта. Google доказал, что можно обучать роботов без заранее запрограммированных ответов, и это открывает новые горизонты в области искусственного интеллекта (глубокого обучения) и машиностроения.

Как утверждает Пинкер, осязание играет центральную роль для людей во время задач захвата и манипулирования. Для людей с ампутированными конечностями, которые потеряли руки, одним из самых больших источников разочарования является неспособность почувствовать, к чему они прикасаются при использовании протезов. Лишенные осязания люди с ампутированными конечностями должны обращать пристальное внимание на зрение во время задач по захвату и манипулированию, в то время как человек без ампутированных конечностей может поднять что-то, даже не глядя на это.

Дюшен утверждает, что настоящий прорыв произойдет, если научить роботов тактильному интеллекту лучше предсказывать хватательные ощущения. Исследователи знают о решающей роли, которую тактильные датчики играют в хватании, и за последние 30 лет было предпринято множество попыток создать тактильный датчик, воспроизводящий человеческий аппарат. Однако сигналы, посылаемые тактильным датчиком, сложны и многомерны, и добавление датчиков к роботизированной руке часто не приводит к улучшению хватательных способностей.

В своей лаборатории Дюшен строит тактильный интеллект с помощью алгоритма машинного обучения, который использует «изображения давления для прогнозирования успешных и неудачных захватов».

В приведенном выше примере Дюшен настроил роботизированную руку с несколькими мультимодальными тактильными датчиками, чтобы робот мог поднимать различные объекты и учиться, собирая входные данные захвата в базу данных нейронной сети. Это превратилось в систему, которая могла предсказывать захват с точностью 80%.

В другом примере они сосредоточились на обнаружении проскальзывания, аналогично тому, как мы, люди, быстро распознаем, когда объект выскальзывает из наших пальцев, благодаря нашим врожденным рецепторам на нашей коже, которые обнаруживают быстрые изменения давления и вибрации. Исследователи смогли ввести в базу данных изображения вибрации (спектрограммы) соскальзывания руки человека. Затем тот же робот использовал алгоритм машинного обучения для прогнозирования проскальзывания объекта с точностью 90%.

Сейчас команда Дюшена тестирует способы автоматического обновления алгоритма кодирования, чтобы каждая попытка захвата помогала роботу научиться делать более точные прогнозы. В долгосрочной перспективе робот сможет использовать эту информацию для корректировки своего поведения во время функции захвата. Согласно исследованию ETS, недостаточно иметь более совершенные захваты (как утверждает Рус) или более надежные датчики компьютерного зрения (как в исследовании Брауна), клей, который буквально скрепляет все вместе, — это развитие нейронной сети «тактильного восприятия», чтобы чтобы робот поднял любой предмет (даже мое пиво), не пролив его.