Прогнозирование эмоций по видео все чаще используется в приложениях, охватывающих здравоохранение и науки о жизни. Крупные поставщики облачных услуг предлагают готовые API-интерфейсы для прогнозирования эмоций, но их точность и интерпретируемость часто не удовлетворяют потребности наших клиентов. Узнайте, как наша команда разработала новый подход к предсказанию эмоций по видео. Здесь мы описываем процесс построения модели, его текущую производительность и будущие соображения.

ВВЕДЕНИЕ

Автор: Майкл Белл и Айрис Гриффит

Распознавание эмоций по лицу (FER) становится все более полезным в приложениях для здравоохранения и наук о жизни, особенно в неврологии, а также в таких областях, как маркетинг, обучение и обеспечение качества услуг, предоставляемых с помощью видеоконференций. В здравоохранении FER может применяться в ряде интересных вариантов использования. Например:

Телемедицинские платформы могут использовать FER на основе AI/ML для расширения существующих рабочих процессов взаимодействия с пациентами, чтобы они могли повысить эффективность и качество лечения. FER позволит поставщикам услуг в области психического здоровья автоматически суммировать и оценивать эмоциональное состояние пациента в течение сеанса или, в долгосрочной перспективе, в течение определенного периода времени, чтобы помочь определить потребности в лечении и измерить реакцию на лекарства или терапию. Это также может позволить поставщикам медицинских услуг аннотировать заметки для записи и поиска тем, вызывающих сильное эмоциональное воздействие на пациента, предлагая поставщикам способ быстро обеспечить качество видеопосещений.

Клинические испытания все чаще проводятся дистанционно и распределенным образом. Распределенные испытания требуют более персонального внимания к участникам, чтобы предотвратить отсев участников и обеспечить вовлечение пациентов в процесс. FER на основе AI/ML обеспечивает основу для быстрой оценки вовлеченности пациентов, чтобы администраторы клинических испытаний могли лучше сосредоточить свои ресурсы при предотвращении выбывания пациентов. Как и в случае телемедицинских услуг в области психического здоровья, видеоанализ пациентов может дать представление о реакции на терапию при очень небольших дополнительных затратах.

Страховщики могут использовать FER для оценки эмоционального и психического состояния своих участников. Эмоциональное состояние сильно коррелирует с другими последствиями для здоровья. В частности, в экосистеме ухода, основанной на ценностях, способность выявлять участников с эмоциональными состояниями беспокойства может ускорить диагностику и вмешательство.

Google и Amazon размещают готовые API распознавания лиц, которые могут возвращать прогнозы эмоций, указывающие, выражает ли лицо человека счастье, грусть или другие эмоции во время видео. Однако на практике мы обнаружили, что результаты, возвращаемые этими API, часто несовместимы с человеческими аннотациями и неспособны отразить поведенческие нюансы. Из-за этих ограничений мы создали собственную модель глубокого обучения, которая лучше подходит для нужд специалистов в области здравоохранения и медико-биологических наук, чем текущие готовые API.

ПОДХОД

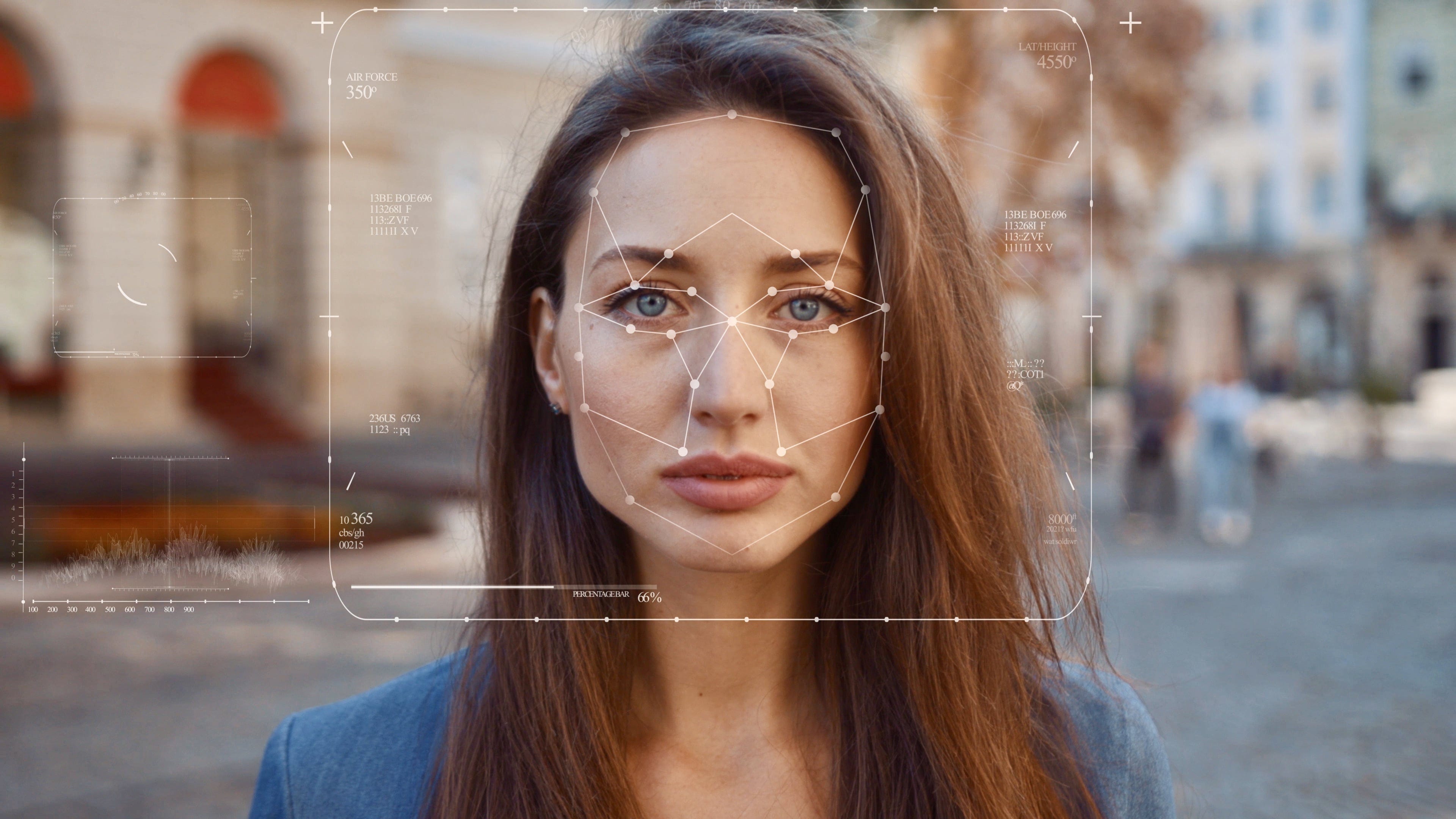

Модель основана на 468 трехмерных ориентирах лица, снятых с помощью Mediapipe. Мы извлекли черты из этих лицевых ориентиров и использовали их для обучения модели ансамбля. Затем мы передали прогнозы ансамблевой модели в метамодель глубокого обучения, чтобы классифицировать и постоянно оценивать эмоции.

Наконец, мы использовали все изученные функции этих моделей для обучения модели UMAP с учителем и кластеризовали преобразованные данные. В конечном счете, этот конвейер моделирования генерирует встраивание лицевых эмоций и позволяет нам проецировать невидимые/будущие данные в это пространство.

Данные обучения для нашей модели соответствовали видеокадрам с размеченными эмоциями из двух наборов данных с открытым исходным кодом: Ravdess и Aff-Wild 2. Перед обучением нашей модели мы сбалансировали метки эмоций, чтобы обеспечить высокую производительность модели по каждой категории (см. таблицу ниже).

ЭМОЦИОНАЛЬНЫЕ ЭТИКЕТКИ

Для проверки производительности модели мы зарезервировали проверочный набор видео и видеокадров, которые не вошли в число видео, найденных в обучающем наборе.

ПОЛУЧЕННЫЕ РЕЗУЛЬТАТЫ

Модель показала улучшенную производительность по сравнению с алгоритмами Amazon и Google. При тестировании на проверочном наборе мы обнаружили, что алгоритм Amazon работает с точностью 69,5 % (усредняется по 5 эмоциям), алгоритм Google работает с точностью 73,3 % (усредняется только по 4 эмоциям), а наша стратегия работает с точностью 73,4 % (усредняется по 4 эмоциям). 5 эмоций). В таблице ниже представлена производительность, предсказывающая отдельные эмоции.

СООБРАЖЕНИЯ

Помимо производительности, эта модель FER имеет ряд преимуществ:

Оптимизировано для AI/ML.Наш подход автоматически генерирует прогнозы для всех видеокадров и может контекстуализировать несколько смежных видеокадров, чтобы суммировать эмоциональную реакцию во времени. Все выходные данные структурированы во временные ряды, которые готовы для последующего анализа данных.

Масштабируемость и низкая стоимость: готовые API прогнозирования эмоций оцениваются в зависимости от объема обработанных видеоданных; однако в масштабе и в случаях, когда необходимо анализировать каждый кадр в каждом видео, это может быть непомерно дорого. Этот подход предлагает более гибкую модель ценообразования для поддержки вариантов использования в масштабе.

Больше конфиденциальности и безопасности.Обработка аудио и видео в средах, требующих высокого уровня конфиденциальности и безопасности данных, является сложной задачей. Чтобы решить проблемы с конфиденциальностью и безопасностью, эту модель распознавания эмоций можно гибко развернуть локально, на периферии или в облаке, гарантируя, что все данные останутся конфиденциальными и безопасными, никогда не выходя из рук доверенных администраторов.

Прозрачность. Готовые API-интерфейсы обеспечивают непрозрачные прогнозы эмоций на основе проприетарных наборов данных без прозрачного контроля версий. Эта модель может быть переобучена для удовлетворения конкретных потребностей проекта, а дополнительные помеченные обучающие данные могут быть включены для настройки производительности и уменьшения систематической ошибки.

ВЫВОДЫ

Во-первых, важно отметить, что модели прогнозирования эмоций не передают настоящие эмоции. Вместо этого они сообщают нам, что кто-то выражает, основываясь на помеченных обучающих образах, кодирующих социальные нормы. На самом деле мы провели углубленное исследование, чтобы понять, как социальные нормы влияют на предсказание эмоций по лицу, и в целом обнаружили, что межкультурных эффектов относительно немного. Тем не менее, для приложений в области здравоохранения и нейробиологии, в частности, важно не относиться к предсказаниям как к истине.

Во-вторых, компаниям, работающим в сфере здравоохранения и медико-биологических наук, требуется более детальное представление эмоций, чем те, которые обеспечивают текущие стандартные модели, которые предсказывают относительно небольшой набор категорий эмоций. С этой целью наш следующий шаг — улучшить способность модели VIVO FER фиксировать тонкие различия лиц, которые охватывают более одной эмоциональной категории.

Наконец, алгоритмы на основе изображений сами по себе недостаточны для захвата всего спектра эмоций. Чтобы повысить производительность наших моделей, мы используем другие функции, захваченные нашей платформой видеоаналитики VIVO, для получения голосовых и текстовых функций, которые обеспечивают необходимый контекст и помогают модулировать результаты, особенно когда субъект говорит (т. е. когда его лицо активно не передает эмоции).

СВЯЗАТЬСЯ С НАМИ

Обладая опытом в области НЛП, машинного обучения, биоинформатики и видео/голосовой аналитики, а также страстью к передовым наукам о данных, наша команда всегда ищет способы улучшить открытия и ускорить ваш потенциал. Если у вас есть вопрос, связанный с ИИ/МО, или вы хотите обсудить свою стратегию ИИ, мы будем рады услышать от вас! Свяжитесь с нами по адресу [email protected] или в LinkedIn.